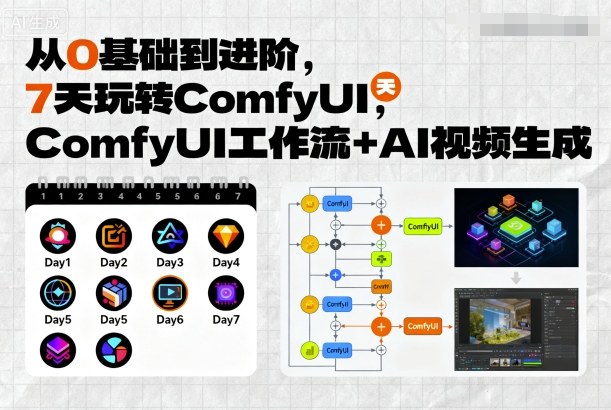

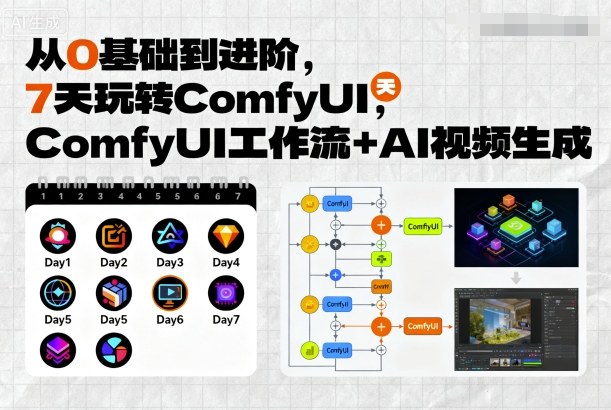

从0基础到进阶,7天玩转ComfyUI,Comfyui工作流+AI视频生成

第 1 天:认识 ComfyUI 与环境搭建

第 2-3 天:基础工作流学习

第 4-5 天:进阶工作流探索

第 6-7 天:AI 视频生成实战

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。

从0基础到进阶,7天玩转ComfyUI,Comfyui工作流+AI视频生成

评论(0)